近日,思科发布了首个AI就绪指数调查报告,这项调查覆盖了全球8000多家公司,旨在衡量企业对人工智能技术的兴趣和利用能力。思科网络业务执行副总裁兼总经理Jonathan Davidson表示:“就像云改变了它所涉及的每个行业一样,我认为AI也将改变它所触及的每个行业。”(文末附调查报告下载)

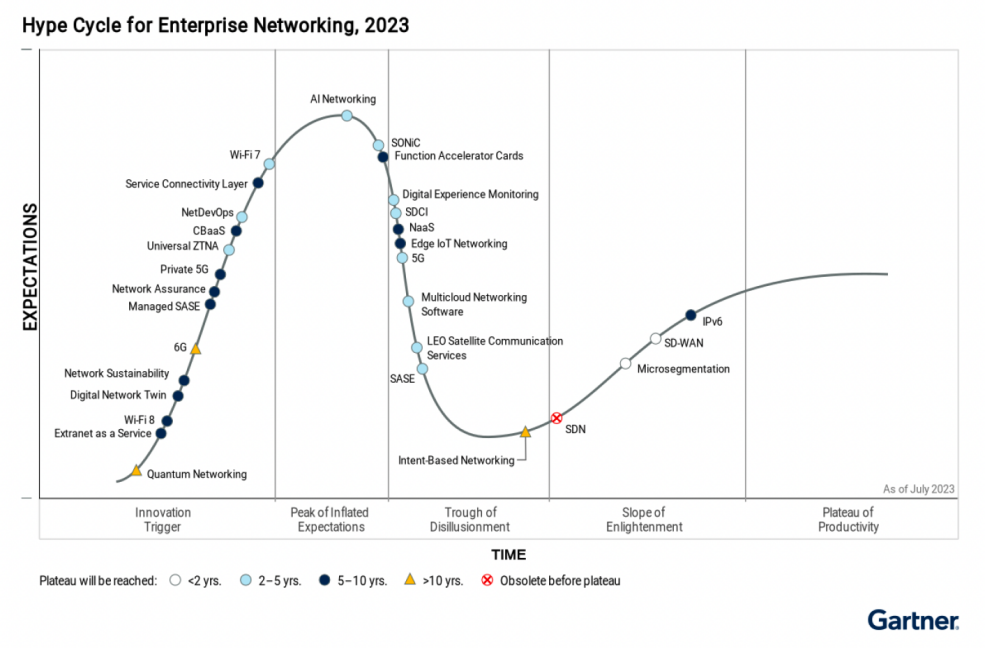

行业人士也已意识到了AI技术的巨大潜力。在Gartner发布的2023年企业网络成熟度曲线中,AI 网络已然登顶。

650 Group在博客中指出,2022 年AI 网络市场规模达到了 20亿美元,其中 InfiniBand 贡献了75% 的收入。展望 2027 年,AI 网络的收入将飙升至超过 100亿美元,其中以太网将超过 60亿美元。以太网和 InfiniBand 都将在此期间强劲增长。与此同时,AI 工作负载的带宽每年增长将超过 100%,远高于典型数据中心每年 30-40% 的带宽增长。

IDC 则表示,企业在生成式人工智能服务、软件和基础设施上的支出将在未来四年内飙升,从今年的 160 亿美元跃升至 2027 年的 1430 亿美元。有些企业似乎将AI网络视为获取竞争优势和领先地位的希望所在,例如思科和Arista。

AI网络,思科的“新地图”

11月16日,思科发布了2024财年第一财季财报。报告显示,思科第一财季净营收为147亿美元,与去年同期的136亿美元相比增长8%;净利润为36亿美元,与去年同期的27亿美元相比增长36%。

思科产品(包括路由器和交换机等)销售额为111.39亿美元,去年同期为102.45亿美元;服务销售额为35.29亿美元,去年同期为33.87亿美元。按产品划分,思科第一财季:

- 来自于网络业务的营收为88.22亿美元,与去年同期相比增长10%;

- 来自于安全业务的营收为10.10亿美元,与去年同期相比增长4%;来自于合作业务的营收为11.17亿美元,与去年同期相比增长3%;

- 来自于“可观测性”(Observability)业务的营收为1.90亿美元,与去年同期相比增长21%。

从财报数字来看,思科第一财季营收超出了华尔街分析师此前预期,但因其对第二财季和全年营收的展望则均未能达到预期,从而导致盘后股价大幅下跌。

对于下调第二财季和全年营收的展望,思科解释,虽然过去几年困扰大多数网络供应商的供应链问题已经减少,但购买和卸载设备的积压导致了新订单放缓,并影响利润。

思科首席执行官Chuck Robbins表示:“估计客户手中还有四分之一到两个季度的已发货订单仍在等待部署,但这并不意味着思科的产品不畅销,之后产品的发货时间、交货时间以及积压订单已基本恢复到正常水平。”Arista 和 Juniper 等供应商也报告了类似的标准化。Arista 最近表示,供应链和交货时间将在 2023 年稳步改善,并预计在 2024 年恢复正常。

关于思科财报的另一个讨论热点是AI网络对盈利的影响。

Robbins表示:“我们看到AI领域的持续发展势头,四大云客户中的三家正在部署我们的超大规模以太网人工智能架构。我们还预计到 2025 财年将为主要云提供商提供超过 10 亿美元的AI基础设施订单。” 思科表示,将继续与主要 GPU 和存储合作伙伴合作,围绕以太网技术、支持 GPU 的基础设施以及联合测试和验证的参考架构创建 AI 网络设备。

思科近期在AI网络领域积极投入了大量的精力,也取得了一定的成果。

6 月,思科在面向AI的新型高端可编程Silicon One处理器取得了全新进展,芯片产品家族又添新成员。全新处理器包括Silicon One G202和Silicon One G200,能够实现25.6Tbps和51.2Tbps的转发性能。两款处理器建立在 Cisco Silicon One G100统一架构的技术基础之上实现突破创新。针对高带宽、超大规模数据中心以及 AI/ML高性能网络进行了全面优化,构建无损、低延迟和高能效的AI数据中心。

9月,思科发布了AI/ML应用的数据中心网络蓝图,定义组织如何使用现有的数据中心以太网来支持AI工作负载。该蓝图的核心组件是思科 Nexus 9000 数据中心交换机,这些交换机的每个 ASIC 高达 25.6Tbps 的带宽,并且拥有可用的硬件和软件功能,可提供所需的低延迟、拥塞管理机制和遥测,可提供 AI/ML 集群所需的极高吞吐量。

此外,思科最近还宣布了来自 Red Hat、Nvidia、OpenAI 和 Cloudera 的四项新的思科人工智能蓝图验证设计,重点关注虚拟化和容器化环境,以及融合和超融合基础设施选项。思科已经在其菜单中加入了来自 AMD、英特尔、Nutanix、Flashstack 和 Flexpod 的经过验证的 AI 模型。

思科认为大多数AI网络的核心将是以太网,因为高带宽以太网基础设施对于促进AI工作负载之间的快速数据传输至关重要。在以太网中实施优先流量控制 (PFC) 和显式拥塞通知 (ECN) 等软件控制,有助于保障不间断的数据传输,尤其是对于那些对延迟敏感的AI工作负载。

一往无前的Arista

Arista 最近也报告了关于AI网络开发的增长,预计 AI 网络试验将于 2024 年开始,生产部署将在 2025 年变得更加广泛,从而带来 7.5 亿美元的 AI 收入。

Arista 与思科是超级以太网联盟(UEC)的创始成员,该联盟旨在为 HPC 环境中的AI工作负载提供新版本的以太网。这与 InfiniBand 相反,InfiniBand 是目前 HPC 的首选网络技术,由 Nvidia支持。

与思科相反,受益于全球企业布局AI的热潮,再加上第三季度强劲业绩以及乐观业绩展望的刺激之下,Arista 近期股价表现较好。公司在今年的AI大会上披露,预计2027年AI网络设备价值将达到50亿美元。

10月 30日,Arista 发布了 2023 年第三季度收益报告显示了强劲的财务业绩。公司收入达到 15.09 亿美元,较 2023 年第二季度增长 3.5%,较 2022 年第三季度增长 28.3%。GAAP 净利润为 5.453 亿美元。

Arista 首席执行官Ullal在财报电话会议上表示:“我认为人工智能网络将越来越有利于以太网,特别是随着超以太网联盟以及他们正在定义规范的工作,我们将看到更多基于 UEC 的产品,更多使用 IP 作为单一协议的后端和前端之间的连接。因此,我们备受鼓舞,尤其是在 2025 年,将有大量的后端产品推出,当然还有基于以太网的前端产品。”

AI网络的部署情况

然而,在AI发展如此迅猛的今天,绝大多数企业尚未做好充分准备。在思科AI就绪指数调查中,只有 14% 的受访组织表示他们已经为部署和利用AI技术做好准备。

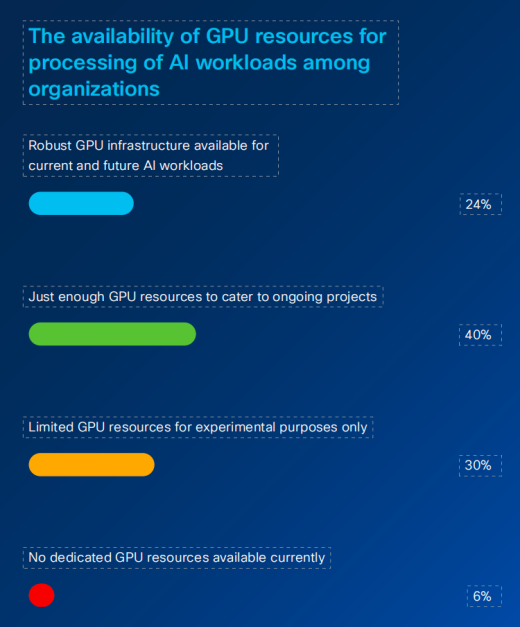

思科发现,当前大多数企业网络都难以应对AI工作负载的挑战。据其调查,约有23%的公司存在可扩展性有限或完全不具备的情况,无法有效应对新的AI挑战。针对不断增长的AI计算需求,超过四分之三的公司表示需要更多的GPU资源,以支持当前和未来的AI工作负载。

调查中指出,虽然 95% 的企业意识到AI将增加基础设施工作负载,但只有 17% 的企业拥有足够灵活的网络来处理人工智能的复杂要求,所以,现阶段大规模部署人工智能还为时过早。

为了做好AI准备,思科建议企业内置自动化工具进行网络配置,以优化AI工作负载之间的数据传输。“自动化减少了人工干预,提高了效率,并允许基础设施动态适应AI工作负载的需求。”

SDNLAB公众号后台回复1123思科调查,即可获取下载链接