我们生活在一个每天都会产生大量数据的数字信息时代。随着物联网设备、自动驾驶汽车、联网家庭和联网工作场所数量的不断增加,数据中心的数据愈加趋向饱和。因此,需要一种解决方案,使数据中心能够处理不断增加的进出和通过数据中心传输的数据量。

数据处理单元,通常称为DPU,是一种新型可编程的高性能处理器,优化执行和加速由数据中心服务器执行的网络和存储功能。DPU 就像 GPU 一样插在服务器的 PCIe 插槽上,它们允许服务器将网络和存储功能从 CPU 卸载到DPU上 ,从而使 CPU 专注于运行操作系统和系统应用程序。DPU 通常使用可重新编程的 FPGA 与网卡相结合来加速网络流量。

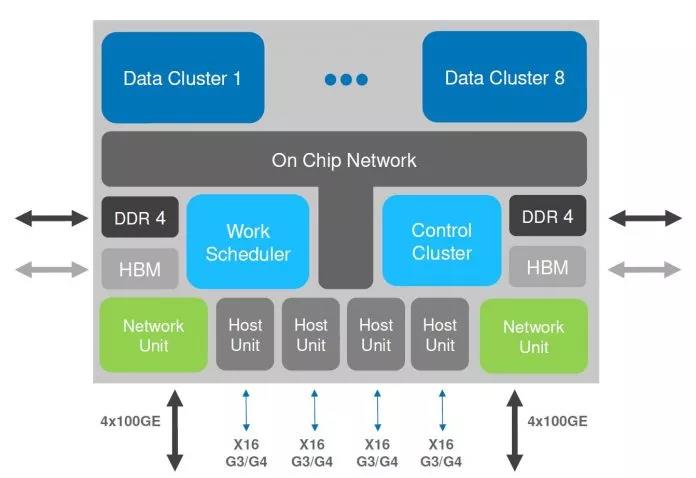

DPU是由三个主要元件组成的片上系统。首先,数据处理单元通常有一个软件可编程的多核 CPU 。第二个元件是高性能网络接口,它使 DPU 能够解析、处理并在网络中有效地传输数据。第三个元件是一组丰富的灵活、可编程的加速引擎,它将网络和存储功能从 CPU 卸载到 DPU。

此外,DPU 可用于处理包括网络安全、防火墙任务、加密和基础设施管理在内的功能。

DPU 最常见的特性是什么?

DPU 具有很多功能,以下是最常见的功能:

1)通过一个或多个 100 Gigabit 到 200 Gigabit 接口的高速连接

2)高速数据包处理

3)基于 ARM 或 MIPS 的 CPU多核处理处理器(8个64位Arm CPU内核)

4)支持 DDR4和DDR5 RAM的内存控制器

5)加速器

6)PCI Express Gen 4 支持

7)安全功能

8)自定义操作系统与主机系统的操作系统分离

常见的 DPU 解决方案有哪些?

2021年4月,英伟达发布了新一代数据处理器BlueField-3 DPU。BlueField-3是首款为AI和加速计算而设计的DPU,相比上一代产品,它具有10倍加速计算能力、16个Arm A78 CPU核,和4倍的加密速度。BlueField-3利用英伟达 DOCA(集数据中心于芯片的架构)软件开发包的优势,为开发者提供一个完整、开放的软件平台,开发在BlueField DPU上开发软件定义和硬件加速的网络、存储、安全和管理等应用。BlueField-3预计将于2022年第一季度发布样品。

赛灵思和英特尔的一些产品被称为SmartNIC ,利用FPGA 来加速网络和存储功能。智能网卡的工作原理与数据处理单元相同,它们将网络功能从CPU 卸载到 SmartNIC,通过将网络和存储功能智能地委托给 SmartNIC ,从而释放处理能力。FPGA 的可重新编程特性,为数据路径带来了并行性和定制化。

例如,赛灵思提供带各种产品的 ALVEO 系列SmartNIC,英特尔及其合作伙伴提供了多种基于 FPGA 的 SmartNIC 解决方案,以加速大型数据中心的数据处理工作负载。英特尔称其 SmartNIC“通过将交换、存储和安全功能卸载到集成了英特尔 FPGA 和英特尔至强处理器的单一 PCIe 平台上来提高数据中心的性能水平。” 英特尔提供了第二个更新的 SmartNIC解决方案,称为 Silicom FPGA SmartNIC N5010,它结合了英特尔 Stratix 10 FPGA 和英特尔以太网 800 系列适配器,为组织提供 4个100 Gigabit 以太网端口,为数据中心提供充足的带宽。

Fungible是一家位于加利福尼亚的组合式系统初创公司。该公司声称其技术能为每100美元的数据中心网络中的网络、计算和存储资源节省67美元。针对以数据为中心(data-centric)应用的处理,Fungible研发了F1 DPU处理器和TrueFabric互联技术。TrueFabric是由Fungible首先提出的新型大规模数据中心网络互联标准,这种Fabric互联协议基于标准的UDP/IP/Ethernet协议栈构建。

还有哪些其他性能加速器?

下面是数据中心中经常使用的一些性能加速器,包括 GPU、CSD和 FPGA。

1.GPU

GPU通常部署在数据中心的高性能服务器上,以加速工作负载。服务器通常会将复杂的数学计算卸载到 GPU。因为GPU 采用了一种并行架构,该架构由许多比 CPU 更小的内核组成,使它们能够并行处理许多任务,从而使组织能够从服务器中提取更多性能。

安装在数据中心服务器上的 GPU 非常适合加速深度学习训练和机器学习训练,这些训练需要大量的计算能力,而CPU无法提供。组织使用 GPU 来训练深度学习和机器学习模型,数据集越大,神经网络越大,复杂的计算需要很长时间。在某些情况下,深度学习训练需要几个小时,但若使用 CPU 执行相同的任务可能需要几天到几周的时间。

此外,将GPU 添加到数据中心服务器可显着提高数据吞吐量,并提供以尽可能低的延迟处理和分析数据的能力。(延迟是指完成给定任务所需的时间量,数据吞吐量是指单位时间内完成的任务数。)

2.计算存储驱动器(CSD)

计算存储已经作为性能加速器进入数据中心,在存储设备级别处理数据,减少了CPU 和存储设备之间的数据传输。计算存储支持实时数据分析,并通过减少输入/输出瓶颈来提高系统性能。CSD看起来与常规存储驱动器相同,但它们包含一个多核处理器,用于执行一些功能,例如在数据进入存储设备时对数据进行索引,并在存储设备中搜索特定条目。

3.FPGA

FPGA是一种集成电路,由逻辑块、I/O单元和其他资源组成,允许用户根据需要执行的工作负载的特定要求以不同的方式重新编程和重新配置芯片。FPGA在执行深度学习推理处理和机器学习推理方面也越来越受欢迎。

在英伟达的带领下,DPU的概念非常火爆。总体而言,由于数据中心中存储的数据量不断增加,需要一种能够加速高性能数据中心服务器执行的存储和网络功能的解决方案,而DPU 可以为现有服务器注入新的活力,发展市场非常巨大,预测到2025年仅中国市场就能达到每年40亿美元的规模,估计全球将超过120亿美元。

原文链接:

https://premioinc.com/blogs/blog/what-is-a-dpu-data-processing-unit