前面几个小的专题讲了讲大二层的常见技术。可以说,大二层在最近几年引领了一波又一波的网络技术革新,从“VLAN+自学习+xSTP”的铁三角到“虚拟机框”技术再到各式各样的隧道技术,技术发展之快令人咋舌,技术种类之多令人眼花缭乱。对于DC网络的管理者来说,如何进行大二层技术的选型想必是一件非常头疼的事情。在对大二层的技术做过详细的介绍后,本专题将作为一个小结,作者将从实际部署的角度谈一谈大二层的组网,哪里有理解不到的地方敬请指正。

传统的二层中xSTP扮演着无可替代的作用,不过它对二层的规模和效率有着相当多的限制。为了摆脱这种限制,“虚拟机框”技术通过将多台物理设备整合为一台逻辑设备,跨物理设备冗余的上行链路被看做一个端口组,在转发上统一对待,不仅形成了逻辑上一个天然无环的拓扑,还可以在端口组上做负载分担,基本上解决了STP的困扰。这类技术很早就得到了广泛的应用,是“大二层”技术中最为成熟的。“虚拟机框”技术有着诸多的优点,但是主要存在着以下两个问题:物理设备间的同步流量远距离或者是跨DC传输很受限制,整合的数量有限,框式一般为2台或者4台;都是私有技术,容易形成厂商锁定。考虑到成本问题,实际部署中这类技术往往用于汇聚/核心层,接入层设备一般不提供支持。

与“虚拟机框”这类控制平面虚拟化不同,隧道技术属于数据平面的虚拟化。隧道技术过对二层帧进行再封装,把底层网络当做是“大二层交换机”的背板走线,底层网络可达之处便是二层网络可及之处,在组网的物理位置上提供了几乎无限的可扩展性。隧道技术种类多种多样,从技术发展和市场趋势来看,数据中心隧道的部署历经四代,逐步朝着“隧道下沉”的趋势演进。

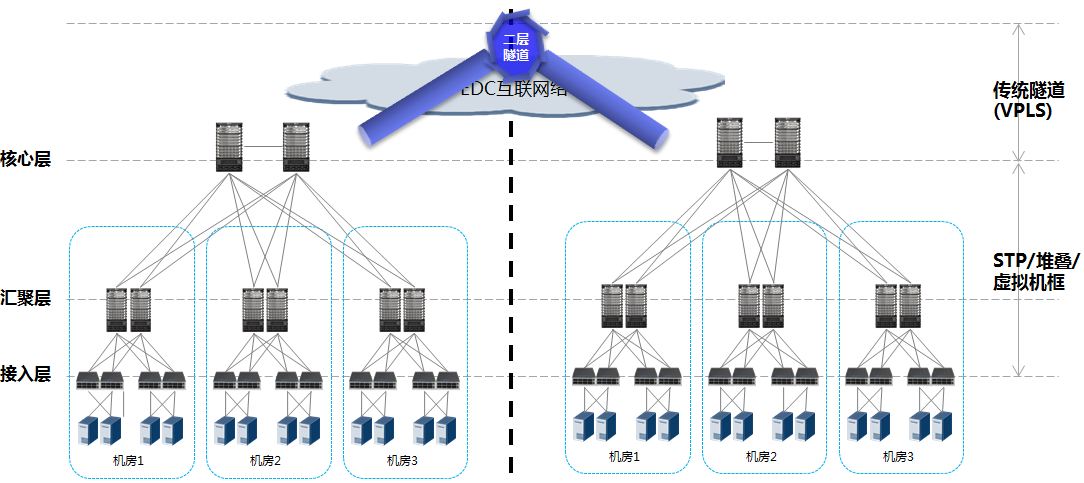

第一代隧道部署位于数据中心间的互联,部署在数据中心核心层出口PE上,实际上就是VPN技术的应用。为了实现跨DC的二层网络,往往使用L2 VPN,以VPLS作为代表技术。隧道终结于DC边缘,DC内部为纯二层环境,通过STP组网,或者使用堆叠/虚拟机框技术。第一代隧道技术,应用部署非常成熟,其问题在于:内部仍为VLAN组网,收到租户数量上的限制;VPLS技术开通复杂,可扩展性差,没有针对DC间流量的优化。

第二代隧道部署,表现在DC间互联隧道从核心层下移到汇聚层,以OTV为代表。针对第一代中VPLS类技术的缺陷进行了优化,主要包括ARP代理,未知流量抑制,出/入向流量路径优化,多宿主双活等等。数据中心内部仍使用STP/堆叠/虚拟机框+VLAN组网。

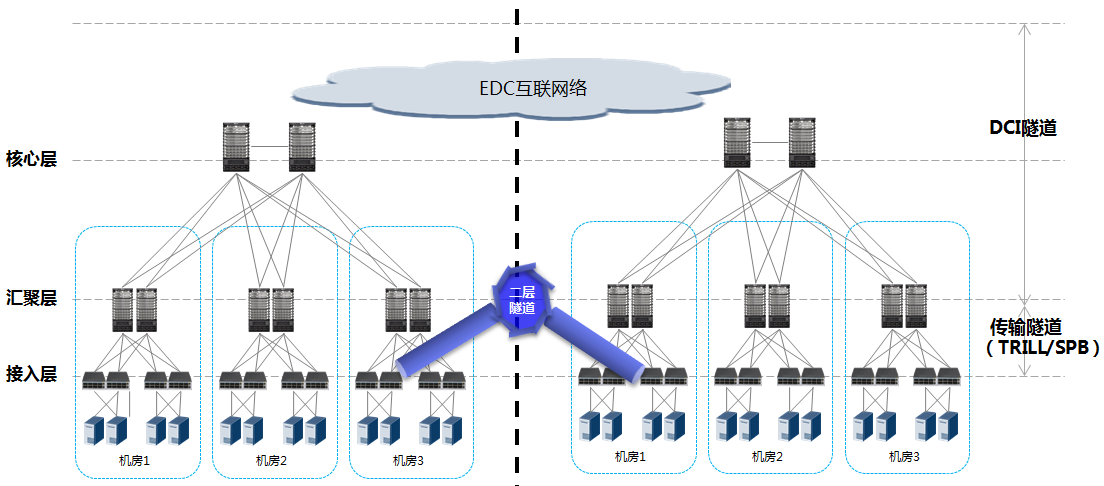

第三代隧道部署,表现在数据中心内部通过隧道优化二层传输,代表技术为TRILL/SPB,部署在接入/汇聚交换机上。相比于堆叠/虚拟机框,TRILL/SPB具有更好的选路智能,二层可扩展性显著提高,不过可能需要代替掉数据中心原有的交换设备。这种部署下,DCI设备模拟的是TRILL/SPB域中连接不同DC中边缘RB/BCB的二层点对多点互联,它能看到的MAC地址是RB/BCB的MAC地址,由于两者都使用了二层的控制协议进行地址学习而非传统的二层自学习,设备的行为也与传统以太网设备有所区别。要配合起OTV/EVN这类DCI技术使用,则需要在相应的TRILL、SPB网关上进行终结,使得OTV/EVN能够发挥自身的特性。当然要是两个域离得不远,比如说一个大楼一个域,那个TRILL本身也是可以作为DCI技术使用的。

第四代隧道部署中,隧道设备将与虚拟机直连,部署在物理接入交换机上甚至服务器内部的HyperVisor中,形成二层端到端的隧道,代表技术为VxLAN。这类技术在接入设备上打隧道,将IP的智能用于传输,可扩展性无限。同时这种部署对传输设备透明,对现网的改造最小甚至能够做到零改造,而且基于应用层的封装也能任意地进行语意的扩展。不过,在获得利用现有设备便利的同时,也意味着传输网络上的选路智能难以做到像TRILL/SPB一样的控制。这种部署方式中,由于中间的underlay网络是IP,因此通过MPLS/BGP VPN这类L3 VPN做DCI是OK的。当然VxLAN的DCI也可以通过VxLAN网关来实现,这需要将一个二层的端到端VxLAN隧道拆成3端。

第一代的部署方式相对陈旧,目前基本已经为后续方式所代替。后面的三代技术,以第二代OTV+VSS组网方式最为成熟,运维经验非常丰富。随着东西向流量的爆发式增长,数据中心业务对于二层网络的选路智能提出了迫切的需求,TRILL/SPB在5年前兴起,带动了数据中心网络的变革。而VxLAN爆发是近两年的事情,其背后是SDN持续火热和OpenStack风靡全球。OpenStack的业务编排加上SDN的灵活控制加上VxLAN的数据封装,这股潮流迅速扫荡云数据中心,IETF专门为之成立了NVo3工作组做着相关的标准化工作。

相比之下TRILL/SPB一来需要设备的升级,二来无法结合SDN的灵活控制,还缺乏端接虚拟机的能力,近年来不禁则黯然失色。TRILL也在尝试着转型,FGL的提出为TRILL提供了与VxLAN相当的租户支撑能力,这意味着TRILL不再只是一种数据平面多虚一的技术,还提供了满足多租户需求的一虚多能力。但是无论如何,目前来说VxLAN+IP向SDN平滑演进的思路显然是更受欢迎的。

数据中心大二层的网络技术就先讲到这里了,有理解不当的地方希望大家不吝指正。其实广义地来看大二层,作者觉得像FcoE这类融合式技术, VEPA、VN-TAG这些虚拟机接入技术,等等都可以被包括进来,在这个专栏里就不细讲了,有兴趣的读者可以到我的博客里面转一转。

后续可能会抽时间做一个SDN虚拟化的专题吧,有兴趣的读者欢迎邮件交流。

作者简介:

张晨,北京邮电大学未来网络理论与应用实验室研究生

主要研究方向:SDN、虚拟化、数据中心

个人博客:sdnv.xyz

个人邮箱:zhangchen9211@126.com

--------------华丽的分割线------------------

本文系《SDNLAB原创文章奖励计划》投稿文章,该计划旨在鼓励广大从业人员在SDN/NFV/Cloud网络领域创新技术、开源项目、产业动态等方面进行经验和成果的文字传播、分享、交流。有意向投稿的同学请通过官方唯一指定投稿通道进行文章投递,投稿细则请参考《SDNLAB原创文章奖励计划》